Vermutlich haben viele schon von ChatGPT gehört, einem KI-Programm, mit dem man sich zu verschiedenen Themen unterhalten kann. Ich will das hier nicht beschreiben, da man sich das besser ->hier anschauen kann.

Das Ergebnis ist gemischt: mal gibt es anscheinend ganz gute Antworten, mal auch nur eloquenten Unfug. Bei bestimmten Themen ist es parteiisch:

Ein weiterer Versuch, sich von dem Programm ein Bewerbungsschreiben produzieren zu lassen, lieferte zwar gute Formulierungen, aber irgendwie keine Gründe, warum man den Betreffenden eigentlich einstellen sollte.

Auf Amazon gibt es derzeit einen Boom an neuen Büchern, die möglicherweise großenteils mit Hilfe der KI geschrieben wurden und einige Verlage haben sogar die Annahme weiterer Manuskripte eingestellt, weil nicht klar ist, ob der Autor nun Mensch oder Maschine ist. Trotzdem ist das NRW-Schulministerium nicht abgeneigt, die KI zuzulassen.

Funktionsweise

Um selbst zu einer Meinung zu kommen, sollte man erst mal wissen, wie das Ding eigentlich funktioniert. Im Prinzip folgt eine solche KI erst einmal der Entwicklung eines Kindes:

(1) Sprechen lernen. Wenn man einen Teilsatz hat, kann man raten, was als nächstes Wort in Frage kommt. Dazu braucht man die Kenntnis der Grammatik und eine Wortliste. Der Start „Das Haus“ verlangt im nächsten Schritt nach einem Verb, könnte also durch „Das Haus fährt“ fortgesetzt werden. Führt man das fort, kommt ein gut lesbarer Satz heraus, der mit hoher Wahrscheinlichkeit völligen Blödsinn enthält.

(2) Was passt wozu? Wenn das Programm viele Sätze als Vorlage hat, wird es feststellen, dass „Haus“ und „fährt“ nicht vorkommt. Im Zusammenhang mit Haus kommen andere Worte in Frage, so dass man bei „Das Haus brennt“ oder „Das Haus ist blau“ oder Ähnlichem landet. Das hört sich dann schon sinnvoll an.

(3) Fortsetzung. Auf die gleiche Weise kann eine KI Sätze aneinander reihen, die insgesamt Sinn machen und einander nicht widersprechen. Es ist nur eine Frage des Aufwands, den man an Beispielen usw. treibt. Die KI kann auf diese Weise auch auf vorgelegte Fragen Antworten generieren, die sinnvoll aussehen. Ob sie hilfreich sind, ist eine andere Frage.

(4) Belohnung. Im nächsten Schritt wird interaktiv mit Menschen agiert. Die Maschine gibt verschiedene Antworten auf Fragen und der menschliche Partner bewertet diese. Findet die Maschine die „richtige“ Antwort, erhält sie eine virtuelle Belohnung, was im Prinzip die Fortsetzung von (2) ist: bestimmte Antworten auf eine Frage erhalten höhere Priorität und werden beim nächsten Mal bevorzugt ausgegeben.

(5) Muster. Der Teilschritt (4) stellt ein Training dar, bei dem der Maschine korrekte Antworten beigebracht werden. In der Echtanwendung wird der Maschine nun eine Frage vorgelegt, die sie noch nicht kennt. Sie hat beispielsweise die Frage „Was frisst eine Möwe?“ trainiert und weiß, was sie antworten muss. Nun erhält sie die Frage „Was frisst ein Albatros?“. Aus Schritt (2) weiß sie, dass ein Albatros und eine Möwe Vögel sind, also wird sie für den Albatros eine ähnliche Antwort generieren wie für die Möwe. Vermutlich liegt sie dann nicht weit daneben, bei einem Kolibri aber vermutlich schon. Wenn nicht genügend Hinweise vorhanden sind, kann die KI auch Fragen stellen oder irgendeine Ausrede produzieren.

Bewertung

Genau genommen unterscheidet sich das nicht allzu sehr von der Entscheidung des Emailprogramms, ob eine Email Spam ist oder nicht. Allerdings unterscheiden sich die Spam-KI und die ChatGPT-KI durch ihre Skalierung¹⁾: während eine Spam-KI leicht verständlich ist, sortiert sie doch eine Mail aus, wenn das Wort „Viagra“ drin auftaucht, sind die ChatGPT-Regeln derart umfangreich, dass man sie als Mensch nicht nachvollziehen kann. Man kann die Antwort nachvollziehen, weil das Gehirn die gleiche produziert, aber da man nicht weiß, wie das Gehirn das macht, weiß man’s von der KI auch nicht.

Da die KI durch die Belohnung in Schritt (4) lernt, Zusammenhänge zu erkennen, erkennt sie allerdings zunächst auch nur Zusammenhänge, die ihr das Training vermittelt. Intelligenzmäßig steht sie damit irgendwo am Ende der Grundschulzeit, wenn sie natürlich auch sehr viel gescheitere Antworten geben kann als Politiker nach 10 Jahren Studium. Ihre Antworten werden demgemäß auch gefärbt sein, wie oben in den Artikeln angedeutet.

Was sie kann, ist tatsächlich eine Form des Denkens mit einfachen Schlussfolgerungen. Was sie (mit hoher Wahrscheinlichkeit) nicht kann, ist das Generieren von Erkenntnissen. Erkenntnisse sind abstrakte Schlussfolgerungen auf der Basis von abstrakten Regeln, die wiederum auf einem axiomatisch abgesicherten System beruhen.²⁾

Wer sich intensiver mit solchen Zusammenhängen beschäftigen will, greife zu den Büchern „Mathematik der Meinungen“ (Grundlagen) und „Evolution der Meinungen“ (Lernzusammenhänge) rechts im Slider.

In der Schule?

Das Ziel der Schule sollte letztlich sein, einen erkenntnisfähigen Menschen in die Realität zu entlassen. „Sollte“, weil die meisten Lehrer das nicht hinbekommen, zum Teil, weil sie selbst nicht über Erkenntnisfähigkeit verfügen, zum Teil aufgrund der Umstände, unter denen sie arbeiten müssen.

ChatGPT liefert dem Schüler nun eine geschliffene Lösung auf eine Aufgabe, die dem Schüler gestellt wurde. Letztlich würde der Lehrer (hoffentlich) diese Lösung ebenfalls präsentieren, aber eben sehr viel später. Zunächst sollte der Schüler aber einen Erkenntnisprozess durchmachen, der vom Lehrer interaktiv langsam in Richtung der geschliffenen Lösung unterstützt wird. Dabei werden die Regelwerke, wie bestimmte Fachgebiete arbeiten, herausgearbeitet. Die geschliffene Lösung ist letztlich nur der i-Punkt des Prozesses und nicht das Wesentliche an der Sache.³⁾

Letztlich ist das somit nur ein Potemkinsches Dorf: der Schüler präsentiert via ChatGPT eine Lösung auf eine Frage, auf die er selbst noch nicht mal kommen könnte, weil ihm dazu die Voraussetzungen fehlen, die Schule kann sich brüsten, wie geschliffen und eloquent sich die Absolventen ausdrücken und das Ministerium kann jede Menge Lehrer einsparen, um Waffen für die Ukraine von dem eingesparten Geld zu kaufen.

Das Produkt kennen wir schon: grün und doof

¹⁾ Der Begriff Skalierung taucht oft bei mir auf, wenn es um grünen Energie- und anderen Blödsinn geht. Was im Kleinen funktioniert, weil es dort überschaubar ist, funktioniert im Großen nicht, weil viele Variablen nicht berücksichtigt werden.

²⁾ Es gibt sehr einfache Axiomensysteme wie beispielsweise das der Grünen. Axiom: es ist das Klima. – Ende der Axiome und der Regeln. So etwas ist eine Ideologie und führt leider nicht zu Erkenntnissen außer der, dass Grüne von Natur aus doof sind.

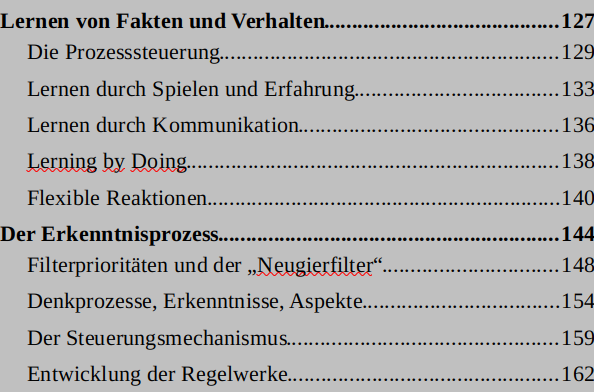

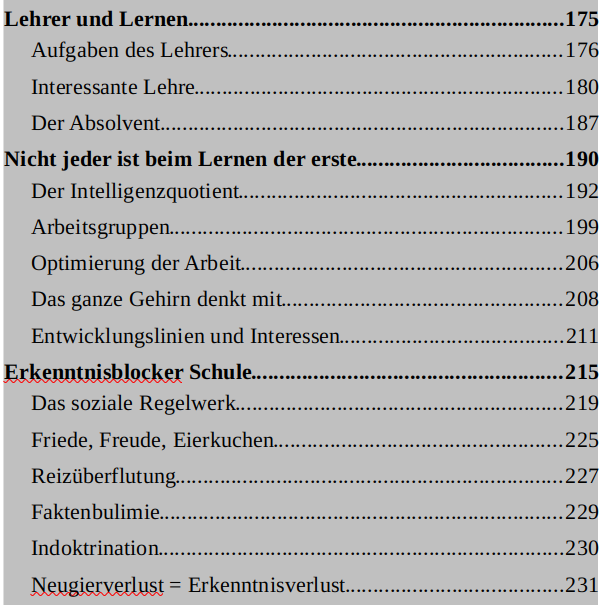

³⁾ Im Band „Evolution …“ ist das Thema mit den folgenden Kapiteln vertreten:

Band 1 ist für das Verständnis der mathematischen Zusammenhänge sinnvoll. Der Rest beschäftigt sich damit, was die Folgen des Ganzen sind.